Wie viele Alarme haben Sie gestern weggeklickt, weil schlicht die Zeit fehlte? Während Security-Teams Tickets sortieren, ändern Gegner im Minutentakt ihre Taktiken. Genau hier kommen AI Security Tools ins Spiel: Sie filtern das Rauschen, heben echte Signale hervor und beschleunigen Entscheidungen. Klingt noch abstrakt? Stellen Sie sich ein Assistenzsystem vor, das Terabytes an Logs liest, sich Normalität merkt und nur dann flüstert, wenn etwas wirklich aus der Reihe tanzt – nicht bei jedem Husten, sondern bei echtem Fieber.

Damit das gelingt, reicht kein schickes Dashboard. Es braucht saubere Daten, passende Modelle und verlässlichen Betrieb. Erst dann wird KI zur Entlastung – und nicht zum nächsten Alert-Generator. In diesem Artikel gehen wir von Netzwerk-Anomalien über Malware-Analyse bis Fraud-Detection. Wir zeigen, wie generative KI Runbooks und Threat Hunting beschleunigt – mit Etappenplänen, Mini-Cases und Tipps zur Integration in Ihren bestehenden Security-Stack. Denn Security ohne Tempo ist wie ein Rauchmelder ohne Batterie: Er hängt an der Decke, aber im Ernstfall bleibt es still. Und Hand aufs Herz: Wollen wir im Ernstfall warten – oder handeln?

KI-gestützte Anomalieerkennung in Unternehmensnetzwerken

KI-gestützte Anomalieerkennung unterscheidet zwischen “normalem” und auffälligem Verhalten in Netzwerkströmen. Ziel ist nicht, jedes Paket im Detail zu analysieren, sondern Muster zu erkennen, die Risiko signalisieren: neue Kommunikationspfade, seltene Ports, ungewohnte Datenmengen, seltsame Zeitprofile. Richtig aufgesetzt, liefert die Methode frühzeitige Hinweise auf Lateral Movement, Datenabfluss oder fehlerkonfigurierte Dienste – lange bevor Signaturen existieren.

Ein kurzer Reality-Check aus dem Alltag: Ein Finance-Server baut plötzlich alle 11 Minuten eine kurze TLS-Verbindung zu einer bisher unbekannten Domain auf. Kein hoher Traffic, keine Malware-Signatur. Die Anomalieerkennung stuft das Muster als Beaconing ein. Ihr Team schaut hin, findet einen kompromittierten Service-Account – und verhindert den Datenabfluss, bevor er beginnt. Genau darum lohnt sich diese Disziplin.

Datenquellen, Features und Modelle: Von NetFlow bis Autoencoder

Die Basis sind Telemetriedaten: NetFlow/IPFIX, DNS- und HTTP-Logs, TLS-Metadaten, Proxy- und Firewall-Events. Daraus werden Features aggregiert – zum Beispiel Verbindungsdauer, Bytes-in/out, Server-Jitter, Portverteilungen, ratio-basierte Kennzahlen und Saisonalitäten pro Host. Häufig werden strukturierte Zeitreihen erstellt (z. B. pro 5-Minuten-Intervall), die Modelle wie Autoencoder, Isolation Forests oder One-Class SVMs füttern. Für kontextreichere Umgebungen bieten sich Graph-Ansätze an, die Hosts, Nutzer:innen und Services als Knoten und Kanten modellieren.

Autoencoder lernen, “Normalität” zu komprimieren. Hoher Rekonstruktionsfehler? Potenzielles Ereignis. Isolation Forests isolieren Ausreißer effizient in hochdimensionalen Daten. Ergänzend helfen Saisonalitätsmodelle (Prophet, STL), um Montagmorgen-Spitzen nicht zu alarmieren. Aber: Kein Modell ersetzt Kontext. Threat-Intelligence, Asset-Kritikalität und Identitätsdaten erhöhen die Aussagekraft erheblich.

Ein praktischer Zusatz: Labeln Sie nicht nur Events, sondern auch Phasen (Erkundung, Lateral Movement, Exfiltration). So kann Ihr System Musterketten erkennen – und priorisieren, was wirklich zählt.

Implementierung in Etappen: Pilot, Rollout und Betrieb mit Metriken

Starten Sie mit einem klar umrissenen Netzwerksegment (Pilot). Formulieren Sie Hypothesen: “Wir erkennen Beaconing in 24 Stunden”, “Wir reduzieren manuelle DNS-Checks um 30%”. Im Rollout folgt die Integration in SIEM/SOAR – inklusive Ticketing, Runbooks und Rückkanal für Analyst:innen-Feedback. Im Betrieb zählen Metriken: Precision/Recall, Mean Time to Detect (MTTD), Mean Time to Triage (MTTT) und Analyst:innen-Zeit pro Alert. A/B-Tests mit Shadow-Mode sind Gold wert – Alerts erzeugen, aber (noch) nicht handeln, um Qualität zu messen.

Pragmatischer Tipp: Führen Sie einen wöchentlichen Drift-Check ein. Visualisieren Sie Feature-Verteilungen, prüfen Sie Top-Knoten im Kommunikationsgraphen und protokollieren Sie Modell-Updates. Kleine Rituale verhindern große Blindspots. Geschwindigkeit ist gut – Vertrauen ist besser. Und noch besser ist beides zusammen.

AI-Security-Tools für Malware-Analyse und Threat Detection

Malware-Analysen leben von Tiefe und Tempo. Signaturbasierte Engines erkennen Bekanntes, doch moderne Kampagnen variieren Artefakte täglich. Deshalb kombinieren viele Teams Sandboxing, statische und dynamische Analyse mit ml-gestützter Sicherheitssoftware. Die Devise: Erst automatisieren, dann die spannenden Fälle in die Tiefe bringen.

Ein Beispiel aus einer IT-Abteilung: Ein verdächtiges Attachment landet montagmorgens im Posteingang. Statt blind zu blocken, geht es automatisiert in die Sandbox, wird dynamisch beobachtet, mit bekannten IOCs abgeglichen – und erst bei eindeutigem Verhalten eskaliert. Das spart Nerven, Zeit und unnötige Eskalationen.

Toolkategorien und Auswahlkriterien: Static/Dynamic Analysis, Sandboxing, EDR-ML

Eine vernünftige Tool-Landschaft deckt die Kette vom Sample bis zum Alert ab. Während statische Analyse schnell Indikatoren extrahiert (Strings, Imports, Entropie), zeigt dynamische Analyse, was die Datei wirklich tut: Prozesse, Registry, Netzwerk. EDR-Lösungen reichern das Ganze endpointseitig an und setzen KI-Modelle für verhaltensbasierte Erkennung ein. Anbieter wie CrowdStrike, Microsoft Defender for Endpoint oder Elastic Security kombinieren diese Ebenen in unterschiedlichen Stärken.

| Kategorie | Zweck | Typische KI-Methoden | Beispiel-Tools |

|---|---|---|---|

| Statische Analyse | Schnelle Indikator-Gewinnung | Klassifikation, Embeddings | Elastic Malware-Modelle, lokale Pipelines |

| Dynamische Analyse | Verhaltensbeobachtung | Sequenzmodelle, Heuristiken | Joe Sandbox, ANY.RUN |

| Sandboxing | Isolierte Ausführung | Anomalie-Scoring | Cuckoo (Self-Host) |

| EDR/ML | Endpoint-Sicht + Prävention | Verhaltensanalyse, Graph-Modelle | CrowdStrike Falcon, Defender for Endpoint |

Auswahlkriterien sind Pragmatismus und Integrationsgrad: API-Reife, Automation (SOAR), Performanz bei großen Sample-Volumina, Kosten pro Host/Scan und die Fähigkeit, neue Kampagnen schnell zu lernen. Wenn Sie viel Cloud-Workload haben, prüfen Sie KI-gestützte Bedrohungserkennung für Container und Serverless – andere Telemetrie, andere Taktiken.

- Klare Ziele definieren: schnellere Triage, weniger False Positives, bessere Coverage.

- Sandbox vs. EDR abwägen: Tiefe Analyse oder breite Abdeckung.

- APIs testen: Wie sauber sind Enrichment und Export ins SIEM?

- Kosten realistisch kalkulieren: Lizenz, Storage, Analyst:innenzeit.

Mini-Case: Ransomware-Erkennung in 15 Minuten – Pipeline vom Sample bis zum Alert

Ein mittelständischer Hersteller integriert eine Pipeline: E-Mail-Gateway leitet unbekannte Attachments in die Sandbox, dynamische Analyse erzeugt Verhaltensprofile (File-Encryptions, Kill-Switch-Test, C2-Callbacks). Features fließen in ein LightGBM-Modell, das mit 5.000 historischen Samples trainiert wurde (Labeling via Analyst:innen-Review). Bei Score > 0,85 sendet das SOAR-System automatisch einen Isolations-Request ans EDR und erstellt ein Ticket im SIEM. Ergebnis: In einem Testmonat sank die Mean Time to Contain (MTTC) von 4 Stunden auf 18 Minuten, ohne zusätzliche Headcount. Klarer Lerneffekt: Gute Features schlagen kurze Trainingszyklen.

Ergänzung aus der Praxis: Das Team ergänzte ein schlichtes Regel-Set (z. B. Massenverschlüsselung + Shadow-Copy-Löschung) als Sicherheitsnetz. Das Hybrid-Modell fing so auch Varianten ab, die sich der dynamischen Analyse teilweise entzogen.

KI-basierte Betrugserkennung im E-Commerce und Zahlungsverkehr

Online-Shops und Zahlungsanbieter kämpfen mit stetig wachsendem Betrugsdruck – von gestohlenen Identitäten bis hin zu Friendly Fraud. Betrugsvorfälle sind selten, teuer und oft gut verschleiert. Genau hier punkten ki-basierte Cybersicherheits-Tools: Sie kombinieren Graph-Signale, Geräte-Fingerprints und Velocity-Muster und treffen in Millisekunden Entscheidungen an der Checkout-Front.

Eine Frage, die wir oft hören: Wie verhindere ich Betrug, ohne ehrliche Kund:innen zu vergraulen? Die Antwort liegt in Kontext – und in klug dosierter Friktion nur dann, wenn sie nötig ist.

Echtzeit-Scoring und Feature-Engineering: Graph-Features, Geräte-Fingerprints, Velocity

Echtzeit-Scoring heißt: Feature-Berechnung in <100 ms, Model-Serving auf stabilen Latenzen. Wichtige Signale sind Beziehungsmuster im Nutzer:innen- und Gerätegraph (geteilte Karten, gemeinsame IP-Cluster, Rücklastschriftenetzwerke), robuste Fingerprints (Canvas, Fonts, OS-Patches, Jailbreak-Indikatoren) und Velocity-Features (Bestell-Häufigkeit, Betragssprünge, Rule-Overlaps). Modelle reichen von Gradient Boosting über Deep Sets bis zu GNNs für Beziehungsgraphen.

Kontext ist kritisch: Ein teurer Erstkauf nachts aus neuer Region ist auffällig – außer, der Kunde hat in den letzten 30 Tagen Reisen gebucht. Darum kombinieren Teams Regeln (sofort verständlich, steuerbar) mit Modellen (generalisierbar, adaptiv).

“Regeln geben Ihnen das Lenkrad, Modelle den Turbo. Die Kunst ist, beides sicher zu fahren.”

| Signaltyp | Beschreibung | Beispiel-Feature | Wirkung auf FPs |

|---|---|---|---|

| Graph | Beziehungen zwischen Kunden, Geräten, Karten | Shared-Device-Ratio | Stark sinkend bei Ring-Fraud |

| Fingerprint | Gerät + Browser-Merkmale | Entropie des Fingerprints | Senkt Spoofing-Fälle |

| Velocity | Tempo und Häufung | Betrags-Sprung-Score | Reduziert Spree-Fraud |

| Identität | KYC/KBA/Verifikation | Dokument-Vertrauensscore | Balanciert Sensitivität |

Mini-Case: Chargeback-Quote halbiert – Regel- und ML-Hybride im Checkout

Ein E-Commerce-Player ergänzt bestehende Regeln um ein XGBoost-Modell mit 300 Features (u. a. Graph-Metriken). Das Serving läuft in 60 ms; nur bei Scores im Graubereich fordert das System 3DS oder ID-Verifikation an. Nach drei Monaten sinkt die Chargeback-Quote von 0,9% auf 0,43%, die False-Decline-Rate bleibt stabil. Ein wöchentliches Champion/Challenger-Setup verhindert Model Drift; neue Muster (z. B. Emulator-Fingerprints) werden als Features nachgezogen. Learning: Soft Friction schlägt harte Ablehnung – Konversion bleibt König.

Ein weiterer, oft unterschätzter Hebel: Post-Event-Feedback aus dem Chargeback-Prozess zeitnah zurückspiegeln. Je schneller Labels zurückfließen, desto länger bleibt Ihr Modell treffsicher.

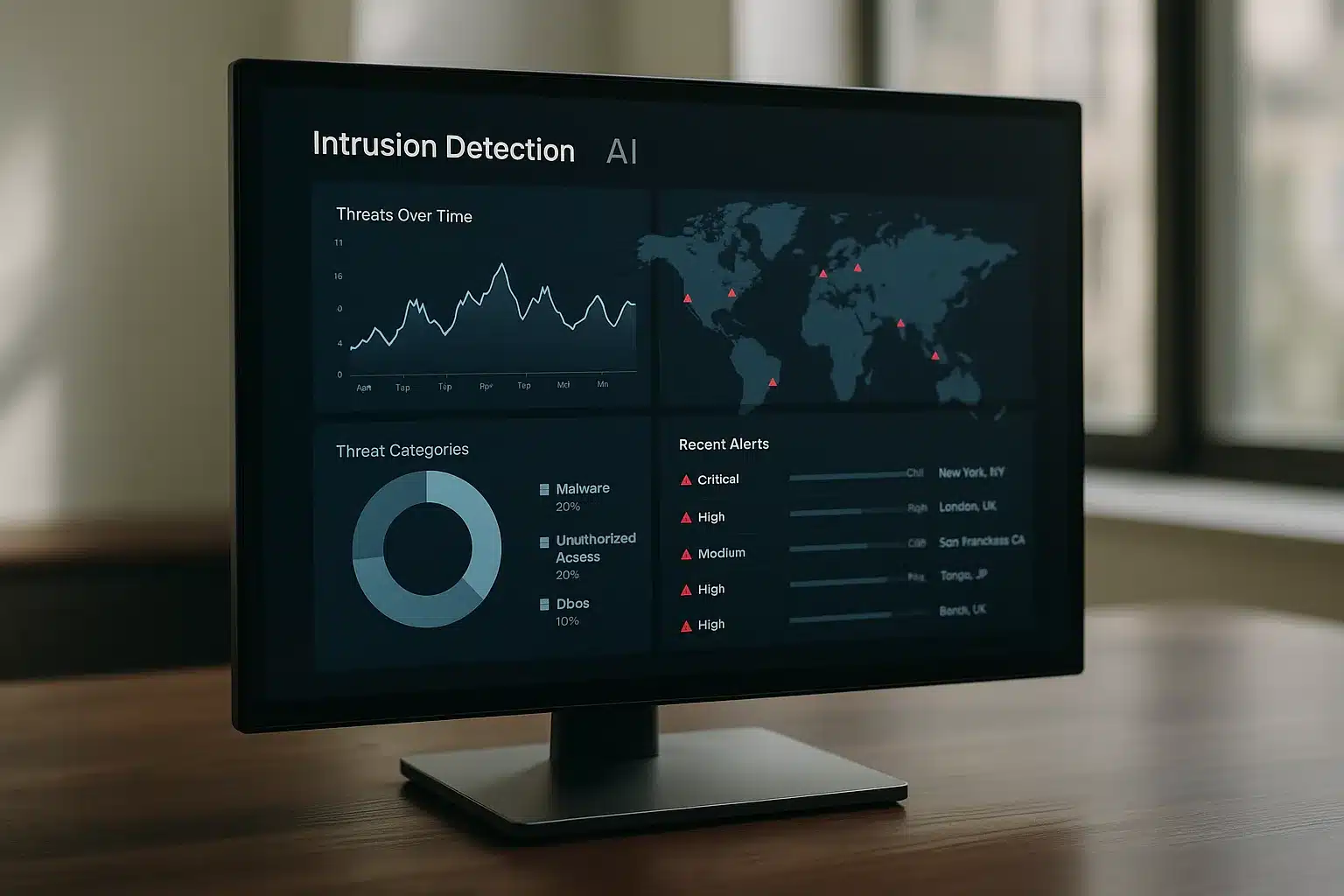

Machine-Learning-IDS: Praxisbeispiele für Intrusion Detection

Intrusion Detection mit ML klingt nach Labor – funktioniert aber im Alltag, wenn Datenfluss, Integration und Analyst:innen-Feedback stimmen. Das Ziel: Angriffe in laufenden Verbindungen erkennen, statt erst im Post-Mortem. Besonders wirksam ist eine Kombination aus Netzwerkperspektive, Endpoint-Verhalten und Playbooks in SOAR.

Ein Micro-Story aus einem SOC: Kurz nach Dienstwechsel meldet das ML-IDS verdächtige SMB-Sequenzen zwischen zwei selten kommunizierenden Hosts. Playbook triggert, PCAP-Snippet wird gesichert, EDR isoliert einen betroffenen Client. 27 Minuten später steht fest: Ein legitimer Admin-Task? Nein. Ein lateral wandernder Dropper – gestoppt, bevor er Rechte ausweiten konnte. Solche Momente bauen Vertrauen auf.

Netzwerk-IDS: Use Cases und Integration in SIEM/SOAR

Use Cases im Netzwerk-IDS reichen von DNS-Tunneling über Beaconing bis zu lateralem SMB-Missbrauch. Modelle lernen Host-spezifische Baselines und melden Abweichungen im Kontext von Kritikalität und MITRE-Techniken. Eine enge Kopplung an MITRE ATT&CK hilft, Alerts strukturierter zu triagieren.

Integration ist der Hebel: Events gehen ins SIEM, Korrelationsregeln verbinden Endpoint- und Identitätssignale, SOAR-Playbooks stoßen Quarantäne, Benutzer-Suspension oder Log-Aufbewahrung an. Wichtig ist Rückkopplung: Analyst:innen markieren True/False Positives, die Pipelines verbuchen Feedback als Label. So wird das System Woche für Woche genauer. Kleine Erfolge motivieren: Ein enttarntes Beaconing nach 12 Minuten Laufzeit schlägt zehn “Vielleicht”-Alarme.

- Drei schnelle Playbooks zuerst: isolieren, Nutzer abmelden, Logs sichern.

- Danach Feinheiten: PCAP-Snippets anhängen, Kontext zu Asset-Kritikalität.

- Feedback-Schleife institutionalisieren: Review-Meetings, Model-Updates.

Verhaltensanalyse mit KI für Endpoint- und EDR-Sicherheit

Auf Endpoints erkennt Verhaltensanalyse Sequenzen: ungewöhnliche Prozessketten, verdächtige Eltern-Kind-Beziehungen, Massenverschlüsselung, Missbrauch legitimer Tools (LOLBins). AI Security Plattformen korrelieren diese Muster mit Threat-Intel und Blocklisten. Ein Beispiel: Ein Script startet wmic, exportiert Prozesse, kontaktiert seltene Domains und exekutiert rundll32 – der Sequenzscore springt, und die Triage startet mit klarer Hypothese.

EDR-Modelle profitieren enorm von sauberem Telemetrie-Design: Eventreduktion am Agent, klare Schemata, stabile Timestamps. Anbieter wie Darktrace oder Elastic Security koppeln diese Erkenntnisse ins SIEM und unterstützen SOAR-Automation – vom Prompt zur Aktion ist es nur ein Klick. Ergebnis: weniger Rauschen, mehr präzise Treffer.

GenAI-Einsatz im Incident Response und Threat Hunting

Generative KI ist kein Orakel, aber ein exzellenter Beschleuniger. Im Incident Response erstellt sie Zusammenfassungen, Übersichten und Handlungsvorschläge – und spart damit die kostbarste Ressource: Zeit. Threat Hunter:innen nutzen LLMs, um Hypothesen zu schärfen, Datenabfragen zu verfeinern und Kontext zu ergänzen. Wer möchte im Feuergefecht lange suchen, wenn Antworten in Minuten erreichbar sind?

Runbooks und Triage beschleunigen: Playbook-Entwürfe, Summaries und User Guidance

LLMs erzeugen Playbook-Entwürfe, die SecOps-Teams kuratieren: Welche Daten prüfen? Welche Eskalationsstufen? Welche Notfallkontakte? Sie schreiben kompakte Summaries für Management-Updates, mappen Telemetrie auf ATT&CK-Techniken und schlagen nächste Schritte vor – inklusive Links zu internen Wissensquellen und externen Referenzen wie NIST SP 800-61.

Im Triage-Alltag helfen GenAI-Assistenten beim Normalisieren von Logformaten und beim Übersetzen von vendor-spezifischen Feldern in ein Common Schema. Sie erklären kryptische Fehlermeldungen, prüfen IOC-Listen auf Duplikate und generieren SOAR-Aktionen. Wichtig: Guardrails. Definieren Sie zulässige Datenbereiche, Logging der Assistentenaktionen und eine menschliche Freigabe für kontextkritische Schritte. Ein schneller Vorschlag ist gut, ein verifizierter ist besser.

Threat-Hunting mit LLMs: Abfragen formulieren, Hypothesen testen, Kontext anreichern

Hunting beginnt oft mit einer Hypothese: “Wenn Angreifer X Taktik Y nutzt, sehe ich Spuren Z.” LLMs helfen, diese Hypothese in präzise Suchabfragen für Ihr SIEM zu übersetzen – inklusive Zeitfenster, Join-Logik und Aggregationen. Sie reichern Treffer mit Kontext an: Asset-Kritikalität, zuletzt gesehene Nutzer:innen, Exposure im Internet, bekannte Schwachstellen.

Ein bewährtes Muster: Co-Piloting. Der Mensch entwirft, das LLM konkretisiert, der Mensch prüft – dann erst ausführen. In Post-Mortems erzeugen LLMs klare Timelines und IOC-Exporte für Partner:innen. Bonus: Automatisierte Lessons Learned, die direkt ins interne Wiki fließen. So wächst aus jeder Krise eine stärkere Praxis.

Fazit und FAQ zu AI Security Tools

KI verändert Security dort, wo Volumen, Geschwindigkeit und Komplexität Menschen überfordern. Ob Netzwerk-Anomalien, Malware-Analyse, Betrugserkennung oder Incident Response – die Mischung aus Datenqualität, Modellen und sauberem Betrieb entscheidet über den Nutzen. AI Security Tools sind kein Selbstzweck, sondern Multiplikatoren für bestehende Prozesse und Teams. Klein starten, schnell lernen, konsequent integrieren. Und immer wieder fragen: Was liefert uns heute messbar mehr Sicherheit?

Welche Daten brauche ich für KI-basierte Security (Netzwerk, Endpoint, Identität)?

Netzwerk: NetFlow/IPFIX, DNS-/HTTP-Logs, TLS-Metadaten, Proxy/Firewall-Events. Wichtig sind stabile Schemas, Zeitstempel und Host-Kontext (Rollen, Kritikalität). Endpoint: Prozess-/Thread-Events, Registry-/File-Operationen, Modul-Ladungen, Command-Line, User-Context, Sensor-Health. Identität: Authentifizierungs-Logs (MFA, SSO), Rollen, Privilegien, Risk-Signale des IdP, Geodaten. Cloud: Control-Plane-Logs, Audit-Events, API-Aufrufe, IAM-Änderungen. Je konsistenter die Telemetrie, desto verlässlicher arbeitet KI für IT-Sicherheit.

Datenhoheit zählt: Minimieren Sie PII, definieren Sie klare Aufbewahrungsfristen und rollenbasierte Zugriffe. Und: Kontextdaten (Asset-Inventar, Schwachstellen, Exposure) boosten Modelle oft mehr als zusätzliche Rohdatenquellen.

Wie gehe ich mit False Positives und Model Drift in der Praxis um?

False Positives senken Sie mit Feedback-Loops, Schwellenwert-Tuning, Context-Enrichment und einem Hybrid aus Regeln und Modellen. Regeln fangen harte No-Gos, Modelle decken Graubereiche ab. Nutzen Sie Champion/Challenger-Ansätze und Shadow-Mode, um Änderungen risikoarm zu testen. Model Drift adressieren Sie mit Monitoring von Feature-Verteilungen, regelmäßigen Re-Trains, abgeleiteten Stabilitätsmetriken (z. B. Population Stability Index) und Dokumentation der Versionen.

Setzen Sie “Quality Gates”: Kein Modell geht live ohne definierte Mindest-Precision und ohne Rückfallpfad. Automatisierte Sicherheitslösungen sind nur so gut wie ihr Betrieb – und der lebt von Transparenz. Wenn alles richtig abgestimmt ist, liefern AI Security Lösungen verlässliche Signale statt weiterer Alarme.

Hey, ich bin Karwl und das ist mein Blog. Ich liebe alles zu den Themen 🌱 Garten & Pflanzen, 🤖 KI & Tech, 🌐 Web & Coding und würde mich freuen, wenn du hier öfters mal vorbei schaust.