Laut mehreren Branchenstudien brechen mehr als die Hälfte der mobilen Nutzer ab, wenn eine Seite länger als drei Sekunden lädt. Drei Sekunden! Das ist weniger Zeit, als du brauchst, um einen Schluck Kaffee zu nehmen. Und selbst wenn sie bleiben, interagieren sie spürbar weniger, sobald Eingaben ruckeln oder Layouts springen. Klingt trivial – ist es aber nicht, wenn man im Alltag zwischen Framework-Updates, Story Points und Deploy-Fenstern priorisieren muss. Genau hier setzt SEO für Entwickler an: als methodische, messbare Erweiterung eures Engineering-Workflows.

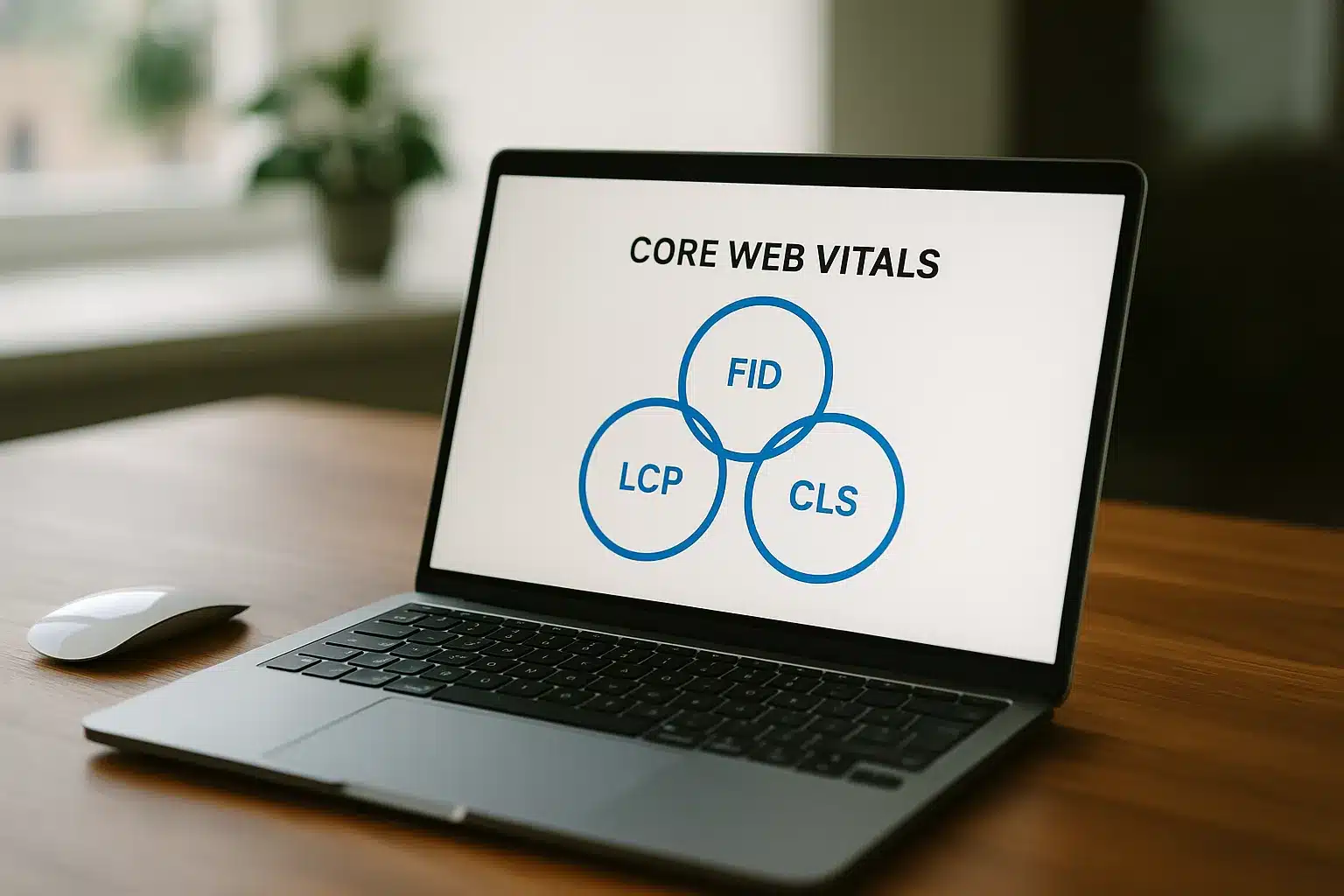

Statt nebulöser Versprechen geht es um konkrete Metriken, reproduzierbare Tests und saubere Architekturentscheidungen. Kurz: weniger Bauchgefühl, mehr Telemetrie. Dieser Guide zeigt, wie du Performance, Rendering, strukturierte Daten und Indexierung so verzahnst, dass Suchmaschinen alles bekommen, was sie brauchen – ohne dass du dein Tech-Stack neu erfinden musst. Wir sprechen über Metriken wie LCP und INP, JSON-LD-Patterns, Crawl-Steuerung und JavaScript-spezifische Kniffe. Keine Alchemie, sondern Engineering mit klaren Feedback-Loops. Und ja: Wir halten es praxisnah, mit Beispielen, die du morgen in den Sprint ziehen kannst.

SEO für Entwickler: Ziele, Verantwortlichkeiten und technisches Mindset

Ein gutes Setup beginnt damit, dass Teams wissen, warum sie etwas tun – und wer wofür zuständig ist. SEO im Engineering-Alltag bedeutet nicht, Keywords zu raten, sondern Signale zu liefern: schnelle Auslieferung, stabile Interfaces, klare Informationsarchitektur und überprüfbare Datenpunkte. Das reduziert Friktion und schafft ein gemeinsames Verständnis von Qualität. Kurzum: schlechte Developer Experience erzeugt schlechte User Experience – und die skaliert direkt in Rankings und Conversions.

Wenn du dir unsicher bist, wo du anfangen sollst, frag dich: Welche technische Änderung würde unseren Nutzern heute sofort helfen? Weniger JavaScript? Eine stabilere Navigation? Genau diese Antworten zahlen auf Suchsignale ein – ganz ohne Buzzword-Bingo.

Wo SEO in den Dev-Prozess passt: Rollen, Schnittstellen, Ownership

In agilen Teams passt techniknahes SEO in Refinements, Definition-of-Done und Release-Checks. Product priorisiert Impact, Engineering implementiert, Analytics misst, und Content/Design liefern die Semantik. Das zentrale Prinzip: Single Ownership pro Thema, sichtbare Akzeptanzkriterien und messbare Outcomes.

Ein Beispiel aus der Praxis: Eine neue Produktseite bekommt Performance-Budgets, strukturierte Daten und einen Rendering-Plan (SSR/SSG). QA prüft Web Vitals in Staging, und Observability (RUM) begleitet die erste Woche nach Launch. Aus „Wir sollten schneller werden“ wird so ein konkretes Paket mit Checkliste und Verantwortlichen.

Noch greifbarer? In einem B2B-Team haben wir „SEO-Guards“ in die DoD geschrieben: „LCP < 2,5 s auf 75. Perzentil“, „HTML-Snapshot vorhanden“, „Schema-Validierung grün“. Das Ergebnis: weniger Diskussion, mehr Geschwindigkeit – und weniger Überraschungen im Go-Live.

Erfolgskriterien: Von Crawling bis Conversion messbar machen

Ohne Metriken keine Priorisierung. Erfolg beginnt beim Crawling (HTTP-Status, robots-Regeln), führt über Indexierung (Sitemaps, Canonicals), geht weiter zur Auswertung von Snippets (CTR) und endet bei Interaktion und Conversion. Das Entscheidende: jede Ebene braucht eine Messmethode. Server-Logs messen Crawler-Aktivität, Core Web Vitals kommen aus RUM und CrUX, während A/B-Tests die Businesswirkung belegen. Ein einfaches Leitbild hilft: „Alles, was wir nicht messen, optimieren wir nicht.“

Frag dich zwischendurch: Würden wir diese Maßnahme auch dann einbauen, wenn wir sie nicht messen könnten? Wenn die Antwort „nein“ ist, fehlt dir noch ein Messpunkt.

Core Web Vitals optimieren für Entwickler: Metriken, Messung, Fixes

Performance ist kein Projekt, sondern ein Budget. Wer konsequent misst und kleine Verbesserungen kontinuierlich shipped, überholt in Monaten komplette Replatforms. Bevor du an einzelne Metriken gehst: Stell sicher, dass du Field-Daten hast – echte Nutzer, echte Geräte, echtes Netz. Lab ist für die Diagnose, Field für die Entscheidung.

Messmethoden und Quellen: Lab vs. Field (CrUX, RUM, Lighthouse)

Lab-Tools wie Lighthouse helfen dir, Bottlenecks zu identifizieren und Regressionen lokal zu verhindern. Field-Daten wie CrUX und eure eigene RUM-Implementierung zeigen die Wirkung auf echte Nutzer. Nutze Lighthouse für Hypothesen, bestätige sie mit RUM. Ein hilfreicher Mix: ein CI-Check mit Lighthouse-Budgets plus ein wöchentliches Dashboard mit CrUX-Verlauf. Vertiefe Grundlagen auf web.dev.

| Metrik | Gute Schwelle (Field) | Primäre Quelle |

|---|---|---|

| LCP | <= 2,5 s | RUM / CrUX |

| INP | <= 200 ms | RUM / CrUX |

| CLS | <= 0,1 | RUM / CrUX |

In einem SaaS-Dashboard senkte ein Team das JS-Bundle um 42% (Code-Splitting + Defer), was den medianen INP um 35% und die Signup-Conversion um 11% verbesserte – gemessen über RUM und A/B-Test. Kleine Schritte, großer Effekt. Ein anderes Beispiel: Eine Medienseite führte Bild-Caching am Edge ein und preloaded das Hero-Image – LCP -28% in zwei Sprints. Kein Big Bang, nur stringente Priorisierung.

- Quick Wins: kritisches CSS inline halten, LCP-Asset früh mit rel=preload laden, Fonts mit display=swap, nicht-blockierendes JS laden, Bildgrößen dynamisch per responsive Images bereitstellen.

Praxis-Fixes pro Metrik: LCP, INP, CLS ohne Rewrites verbessern

LCP: Reduziere Time-to-First-Byte (Caching, Edge), priorisiere das größte Above-the-Fold-Element, nutze effizientere Formate (AVIF/WebP) und setze Preload für Hero-Images. Ein schnelles CDN-Rule-Set und zwei Media-Queries können hier Wunder wirken.

INP: Vermeide lange Tasks (unter 50 ms), nutze Scheduler und IdleCallbacks, entkopple teure Events, und verschiebe Nicht-Kritisches aus dem Main Thread. Praktischer Kniff: Input-Handler klein halten, teure logische Pfade per requestIdleCallback oder OffscreenCanvas auslagern.

CLS: Reserviere Platz mittels width/height oder CSS aspect-ratio, lade Ads/Embeds mit festen Containern, und verhindere late-loading UI-Elemente über stabilen Renderflow. Wenn ein Element springen kann, wird es springen – gib ihm also vorher ein Bett.

Die Regel lautet: „Erst Bytes, dann Runtime.“ Wer weniger ausliefert, muss weniger optimieren. Oder anders gefragt: Warum einen 400-kB-Komponentengarten pflegen, wenn 120 kB die gleiche Aufgabe sauberer erledigen?

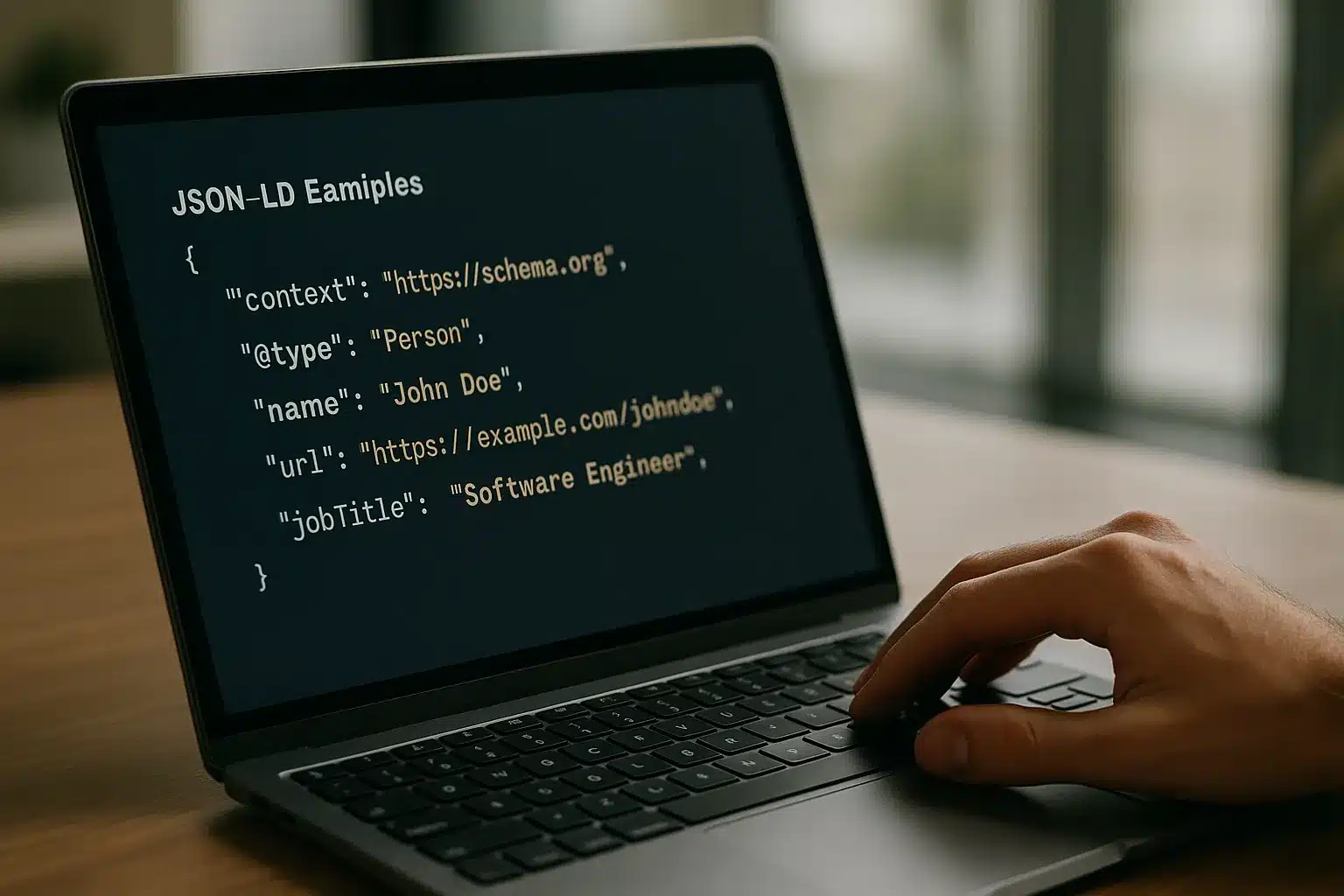

Strukturierte Daten (Schema.org) mit JSON-LD implementieren: Patterns, Validierung, Beispiele

Strukturierte Daten sind die Brücke zwischen Inhalt und Maschinenverständnis. Sie liefern Suchmaschinen präzise Hinweise, was eine Seite darstellt – Artikel, Produkt, FAQ, Organisation. Für Engineering-Teams sind JSON-LD-Snippets ideal, weil sie unabhängig vom Markup verwaltbar sind, testbar bleiben und sich gut in Templating integrieren lassen.

Implementationsmuster: Article, Product, FAQ, Breadcrumb & Organisation

Für wiederkehrende Seitentypen lohnen sich zentrale Serialisierer. Ein Beispiel: Eine „Article“-Factory, die Titel, Datum, Autor, Bilder und Publisher abbildet. „Product“ braucht Preis, Verfügbarkeit und SKU, „FAQPage“ die Frage-Antwort-Paare, „BreadcrumbList“ die Hierarchie, „Organization“ das Brand-Setup (Name, Logo, Social Profiles).

| Typ | Kernfelder | Hinweise |

|---|---|---|

| Article | headline, datePublished, author, image | Optional: speakable, dateModified |

| Product | name, sku, offers, aggregateRating | Preise und Währung normiert pflegen |

| FAQPage | mainEntity (Q/A-Paare) | Antworten nicht duplizieren |

| BreadcrumbList | itemListElement | IDs stabil halten |

| Organization | name, logo, sameAs | Logo mit fixen Maßen |

Bei Internationalisierung sollten IDs, URLs und Sprachen konsistent bleiben. Für dynamische Inhalte eignet sich ein „SchemaContext“ im Code, der pro Template datengesteuert JSON-LD ausgibt. Als Referenz lohnt sich Schema.org. Ein kleiner Tipp aus Projekten: Haltet Bild-URLs stabil und vermeidet Query-Strings in wichtigen Feldern – weniger Fehler im Parsing, weniger Diff-Noise in der CI.

Validierung und Monitoring: Rich Results Test, Search Console, Alerting

Teste jede Variante mit dem Rich Results Test und monitore die Ausspielung in der Google Search Console. Rich-Result-Reportings zeigen Typen, Fehler und Validierungsstatus. Für Monitoring im Betrieb: Baue eine Staging-Prüfung in die CI, die JSON-LD-Blöcke parst, Felder validiert und Regressionen verhindert. Ein Alert bei Template-Änderungen spart später viel Debugging. Wichtig: SEO-Events wie Schema-Fehler sollten im gleichen Incident-Channel landen wie Performance-Regressionen. Du willst doch nicht erst aus einem Ranking-Drop lernen, dass ein Feldnamen-Refactor das JSON-LD zerlegt hat, oder?

Indexierung und Crawl-Budget für große Websites steuern: Architektur, Signale, Robots

Große Sites scheitern selten an Inhalten – sie scheitern an Ordnung. Suchmaschinen crawlen, was sie für wichtig halten, nicht was du für wichtig hältst. Deshalb braucht es eine Architektur, die Signalschichten sauber trennt: Server-Responses, interne Verlinkung, Sitemaps, Canonicals und noindex/nofollow-Regeln. Wer das konsistent implementiert, spart Crawl-Budget und steigert die Trefferquote wertvoller Seiten.

Crawl-Steuerung: robots.txt, XML-Sitemaps, Statuscodes, Parameter-Handling

Robots.txt ist ein Skalpell, kein Beil. Blockiere nur, was nie indexiert werden darf (z. B. interne APIs), und nutze Sitemaps für priorisierte, kanonische URLs. Statuscodes sind Nicht-Verhandlungsmasse: 200 für gültig, 301/308 für Umzüge, 404/410 für wegfallende Inhalte. Parameter-Handling sollte entweder serverseitig normalisieren (Rewrite auf kanonische Pfade) oder mit Canonicals klar kommuniziert werden. Duplicate-Content-Probleme löst man über klare Kanonisierung und eine flache, thematische IA.

Tipp: Ein 304 “Not Modified” spart Re-Crawls. Nutze ETags oder Last-Modified konsequent – besonders bei großen Katalogen.

Ein kurzes Reality-Check-Beispiel: Ein Marktplatz mit Millionen URLs sah in den Logs, dass Bots 70% der Zeit auf Sortier- und Filterkombinationen hingen. Zwei Wochen Arbeit – konsistente Canonicals, Facetten-Whitelist, 410 für tote Filter – und das Crawl-Budget wanderte sichtbar zu Kategorien und PDPs. Die Indexierungsquote stieg, der Traffic folgte.

SEO Logfile-Analyse für DevOps und Engineering Teams

Logs sind der Ground Truth für Crawling. Analysiere, welche Bots was wie oft abrufen, welche Statuscodes sie sehen und wie stark Throttling greift. Ein konkreter Case: Ein Retailer reduzierte unnötige Bot-Hits auf Filterseiten um 63% durch verbesserte Canonicals und ein konsistentes Facetten-Schema. Ergebnis: Mehr Crawl auf Produktdetailseiten und 14% mehr indexierte Top-Performer. Praxis-Setup: Nginx/Apache-Logs in ein zentrales Warehouse streamen, regelmäßige Abfragen (z. B. Top 100 Pfade pro Bot, 5xx-Rate, ansteigende 404s), plus ein wöchentliches Crawl-Budget-Review. Was man nicht sieht, kann man nicht steuern. Und mal ehrlich: Wann hast du dir zuletzt die 304-Rate angeschaut?

JavaScript SEO Best Practices für Single-Page-Apps + Lighthouse/PageSpeed Insights im Entwickler-Workflow

SPAs sind großartig für UX – solange Rendering-Strategie und Auslieferung stimmen. Wenn Bots erst rendern müssen, bevor sie Inhalte finden, steigt das Risiko für Lücken bei Indexierung und Snippets. Die gute Nachricht: Mit dem richtigen Setup aus SSR/SSG/ISR, Routen-Design und hydrationsfreundlichen Komponenten bekommt ihr die Vorteile moderner Frameworks ohne SEO-Kompromisse.

Rendering-Strategien: SSR, SSG, ISR, Prerendering, Hydration, Routing

Wähle die Strategie pro Seitentyp: Marketing-Landingpages via SSG oder ISR für sofortige Inhalte und schnelle TTFB, produktive Dashboards via CSR mit gezielter Defer-Logik. SSR hilft, initialen HTML-Content auszuliefern, während Hydration interaktive Inseln aktiviert. Prerendering eignet sich für stabilen, selten wechselnden Content. Routing sollte indexrelevante Pfade als saubere, statische URLs führen und Tiefe begrenzen. Anbieter wie Vercel vereinfachen ISR/Edge-Rendering erheblich. Wichtig: Progressive Enhancement bleibt die beste Versicherung – wichtige Inhalte müssen im HTML stehen.

- Workflow-Check: CI mit Lighthouse-Budgets, PSI für Feldnähe, RUM im Betrieb, HTML-Snapshots für kritische Routen, wöchentlicher SEO-Tech-Durchgang in der Grooming-Session.

Ein kurzer Real-World-Moment: Ein Team migrierte eine Legacy-SPA zu partieller SSR. Start mit drei Marketingrouten, HTML-Snapshots im Build, Hydration-Inseln für Formulare. Nach vier Wochen: schnellere Snippets, bessere Indexierungsrate, INP stabil unter 200 ms. Kein Big Rewrite – nur eine saubere Rendering-Strategie.

Fazit und nächste Schritte für Entwickler-Teams

Baue einen schlanken, wiederholbaren Loop: Hypothese (z. B. „LCP sinkt durch Preload“), Umsetzung im Branch, Lab-Verifikation, Rollout hinter Feature-Flag, Field-Messung, Post-Mortem. Dokumentiere als Engineering Decision Record, damit das Wissen erhalten bleibt. Starte mit einem „Performance Baseline Sprint“, definiere Budgets und richte Alerts ein. Danach jeden Sprint eine kleine SEO-Kachel – kontinuierlich statt heroisch. Geschwindigkeit ist ein Feature. Verlässlichkeit auch. Und falls du gerade denkst: „Wo anfangen?“ – pick dir eine Route, setz ein Budget, miss den Effekt. Der Rest folgt.

FAQ zu SEO für Entwickler

Wie priorisiere ich SEO-Tickets im Sprint ohne Velocity zu verlieren?

Denke in Impact-per-Story-Point. Lege für jede Maßnahme einen erwarteten Effekt und eine Messmethode fest (z. B. „CLS < 0,1 auf PDPs via aspect-ratio“ gemessen per RUM). Kleine, wiederholbare Tasks gewinnen: Bild-Pipeline optimieren, Preload-Regeln ergänzen, strukturierte Daten zentralisieren. Schaffe außerdem verbindliche Definition-of-Done-Punkte: Performance-Budget in CI, HTML-Snapshot der wichtigsten Routen, Validierung von JSON-LD. Wenn alles messbar ist, lassen sich Tickets mit Product leichter handeln – und du schützt die Team-Velocity. Bonus: Erfolge werden sichtbar, was die nächste Priorisierung vereinfacht.

Sollte ich dynamisches Rendering oder SSR für eine bestehende SPA wählen?

Dynamisches Rendering war ein Notbehelf für Bots – heute ist SSR/SSG/ISR fast immer die robustere Option. Für Legacy-SPAs kann ein modernes SSR-Setup schrittweise eingeführt werden: Zuerst kritische Marketingrouten serverseitig rendern, dann nach und nach weitere Pfade migrieren. Prüfe dabei, ob Inhalte ohne clientseitiges JS sichtbar sind, und halte Interaktivität modular. Ein Zwischenschritt kann Prerendering für feste Routen sein. Miss die Wirkung: Indexierungsrate in der Search Console, Snippet-Qualität, Core Web Vitals. Wenn Deploy-Fenster eng sind, starte mit wenigen, hochrelevanten Routen – der Nutzen zeigt sich häufig schon nach Wochen.

Zur operativen Begleitung lohnt ein klarer Monitoring-Stack und ein gemeinsamer Kanal zwischen Dev, SEO und Product. Und als Grundregel gilt: erst Inhalte zuverlässig ins HTML, dann progressive Interaktion nachladen.

Hey, ich bin Karwl und das ist mein Blog. Ich liebe alles zu den Themen 🌱 Garten & Pflanzen, 🤖 KI & Tech, 🌐 Web & Coding und würde mich freuen, wenn du hier öfters mal vorbei schaust.