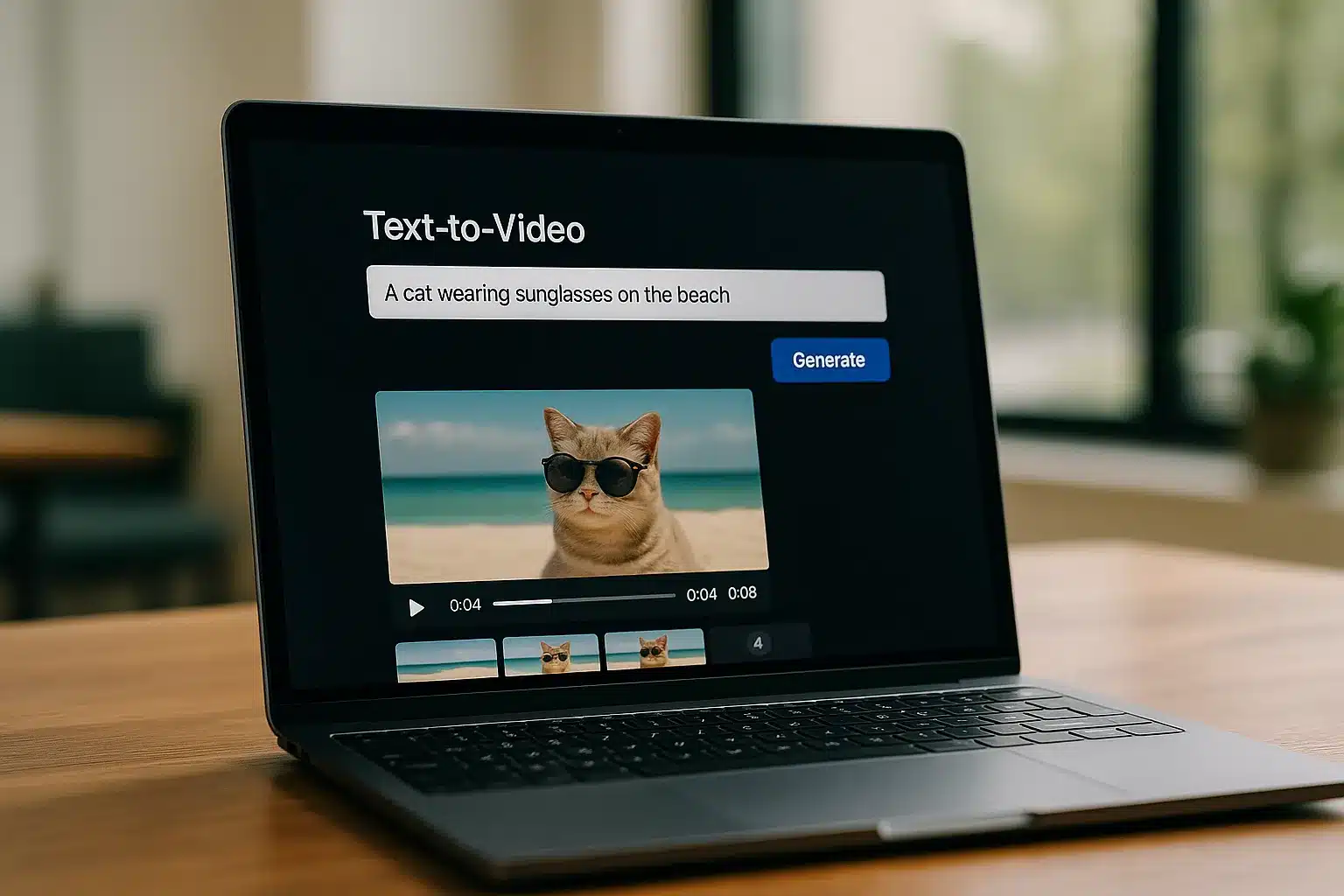

Was wäre, wenn Sie aus einer knappen Textbeschreibung in wenigen Minuten ein packendes Video zaubern könnten? Kein Casting, kein Drehplan, keine Location-Suche – nur Worte, die zu bewegten Bildern werden. Genau das verspricht AI Text to Video. Und ja: Monat für Monat werden die Ergebnisse sicht- und messbar besser.

Wofür taugt das schon heute, wo liegen die Grenzen – und wie holen wir als Creator, Marketer oder kleines Team das Maximum raus? In den nächsten Abschnitten bekommen Sie einen klaren, praxisnahen Überblick: wie die Systeme ticken, worin sich Pika und Runway unterscheiden, welche Schritt-für-Schritt-Workflows funktionieren, was rechtlich zählt und welche Prompt-Taktiken zuverlässig bessere Clips liefern. Anschnallen – die Skriptzeile wird zur Kamera.

AI Text to Video verstehen: Funktionsweise, Einsatzszenarien, Grenzen

Die Idee ist simpel, die Wirkung groß: Aus Textbeschreibungen entstehen Videoclips – von Sekunden-Snippets bis zu kurzen Szenen. Unter der Haube arbeiten Modelle, die Sprache verstehen und in visuelle Dynamik übersetzen. Klingt magisch, ist aber Mathe mit Stil.

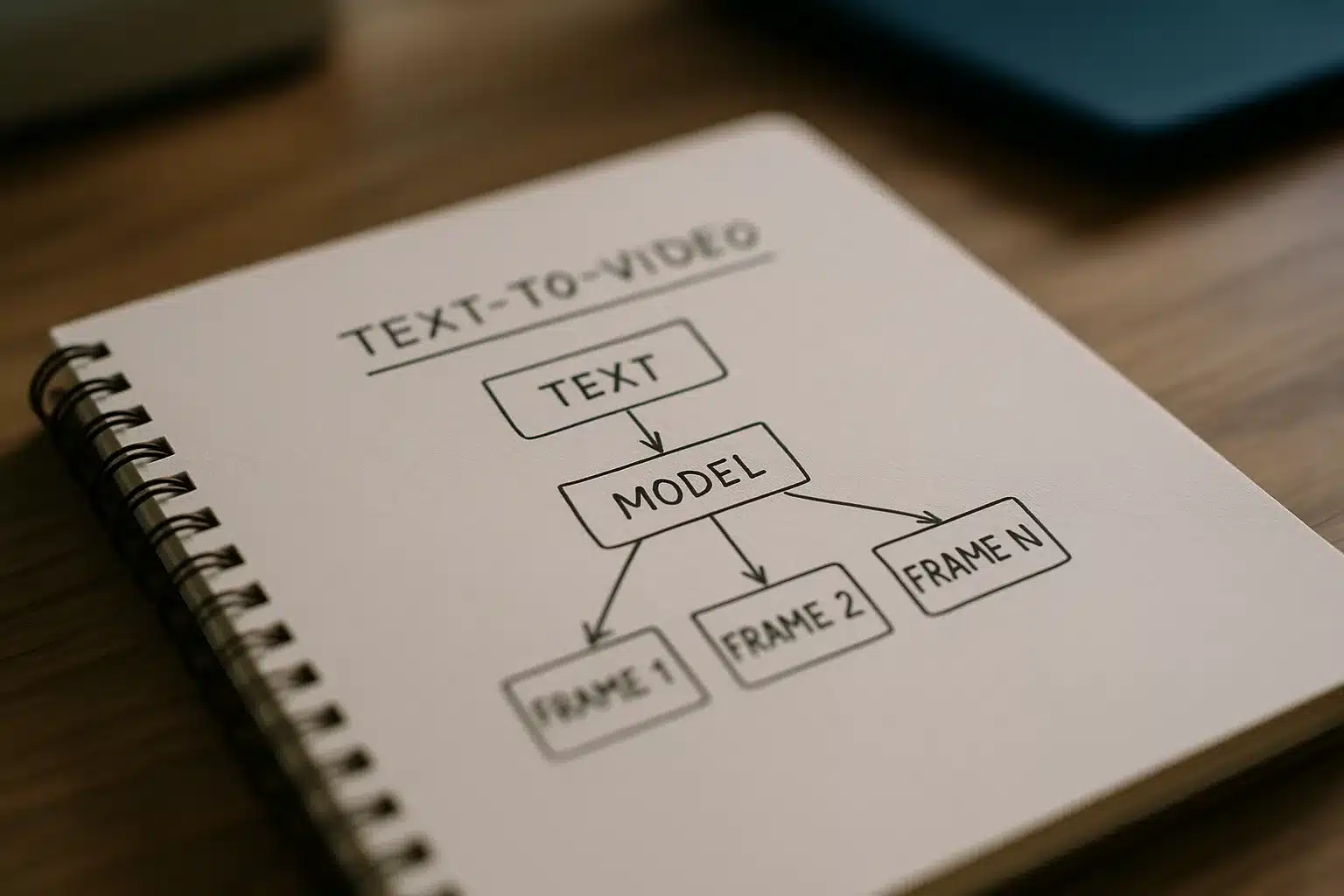

Wie generative Modelle Text in Bewegtbild übersetzen

Viele aktuelle Systeme kombinieren Text-Encoder (meist Transformer) mit latenten Diffusionsmodellen. Erst wird der Prompt in einen semantischen Vektorraum übertragen. Dann „malt“ die Diffusion aus Rauschen Schritt für Schritt ein konsistentes Bild – erweitert um Zeit. Temporal Attention, 3D-consistent Latents und Motion-Module sorgen dafür, dass Objekte von Frame zu Frame ihre Form behalten und Bewegungen glaubwürdig wirken.

Dazu kommen Kontrollinstrumente: Tiefen- oder Kantenmaps, optischer Fluss, Kamera-Pfade und Seeds. Damit steuern Sie Perspektive, Timing und Stil fast wie am Set. Wichtig: Video ist mehr als 24 Einzelbilder. Erst wenn die Übergänge sitzen, fühlt es sich filmisch an. Kurz gesagt: Bewegung ist die halbe Glaubwürdigkeit – und Timing der Rest.

Praxisbeispiele: Wo Text-zu-Video heute überzeugt – und wo nicht

Richtig stark ist die Videogenerierung aus Text bei Mood-Clips, B-Roll, Produkt-Teasern, Previsualization und Social-Shorts. Ein Beispiel aus der Praxis: Eine D2C-Sportmarke ersetzte frühe Shootings für Ad-Tests durch synthetische 6–8-Sekunden-Clips. Prompt: „Running shoes in neon rain, low angle, droplets, slow push-in.“ Ergebnis: zwei Wochen schneller zur ersten CTR-Messung, rund 65 Prozent weniger Produktionskosten in der Testphase. Tempo schlägt Perfektion.

Wackeliger wird’s bei komplexen Hand-Interaktionen, präzisem Lippen-Sync, längeren Erzählketten mit konsistenter Figur – und eingeblendete Texte können flimmern oder „zerlaufen“. Realistische Physik (Flüssigkeiten, Stoffe) schwankt: mal erstaunlich gut, mal daneben. Die Lösung aus der Praxis: kurze, präzise Shots generieren, dann im Schnitt kombinieren. Wer in Sequenzen denkt, gewinnt. Oder anders gefragt: Muss wirklich ein 20-Sekunden-One-Take sein – oder reichen drei knackige 6-Sekunden-Shots?

AI Text-zu-Video: Pika vs. Runway Vergleich

Pika und Runway gehören zu den gefragtesten Tools, wenn schnell greifbare Ergebnisse her müssen. Beide sind ein niedriger Einstieg ins Thema, unterscheiden sich aber im Regie-Feeling, in den Kontrollen und im Ökosystem. Oft ist die Wahl weniger Glaubensfrage als Deadline-Entscheidung.

Stärken, Schwächen und passende Use Cases

Pika punktet mit flinker Iteration, gutem Motion-Handling bei kurzen Szenen und brauchbaren Style-Presets. Ideal für Social-Assets, schnelle Konzeptvisualisierungen und stylisierte Loops. Runway überzeugt mit breiten Kreativ-Optionen, soliden Compositing-Features und einem Editor, der Post-Work erleichtert. Wer Shots verbinden, Farbe, Geschwindigkeit oder Ton nachziehen will, fühlt sich hier zuhause. Faustregel: Pika für rasche Ideenfindung, Runway für das Feintuning bis zur Ausspielung. Und klar: Beide entwickeln sich rasant. Heute fehlt ein Regler – nächste Woche ist er da.

Zur Orientierung hilft ein Schnappschuss der Kernunterschiede:

| Kriterium | Pika | Runway |

|---|---|---|

| Bediengefühl | Sehr schnell, experimentell | Studiolike mit integrierter Post |

| Steuerung | Seeds, Styles, einfache Kamera | Kamera-Pfade, Keyframe-nahe Steuerung |

| Stärken | Schnelle Ideation, stylisierte Clips | Konsistenz, Editing, Ausspielung |

| Schwächen | Weniger Post-Kontrolle | Rendering teils länger bei High-Quality |

| Geeignet für | Social Teaser, B-Roll, Loops | Ads, Promos, Kurzszenen mit Schnitt |

Ein Satz, der oft stimmt: Erst mit groben Strichen malen – dann in Ruhe verfeinern.

Alternativen: Beste Text-zu-Video Tools für Creator 2025

Der Markt bewegt sich schnell. Manche Lösungen zielen auf fotorealistische Bewegungen und Kamerafahrten, andere auf animierten Illustrationsstil. Besonders spannend: Systeme mit Referenz-Uploads (Bild/Video), ControlNet-ähnlichen Steuerungen und konsistenten Charakteren über mehrere Shots. Achten Sie auf Prompt-Flexibilität, Framekonsistenz, Motion-Qualität, Lizenzbedingungen und Exportformate. Eine Plattform kann selten alles – kombinieren ist erlaubt.

Bewährt hat sich ein hybrider Stack: Ideen blitzschnell in Pika anlegen, dann in Runway ausarbeiten und final im NLE graden. AI Text to Video fügt sich als Baustein nahtlos in bestehende Pipelines ein.

Praxis: Pika und Runway Schritt-für-Schritt mit Beispielen

Theorie ist nett – am Ende zählt das erste brauchbare Ergebnis. Hier zwei kompakte Workflows, die Sie sofort testen können. Denken Sie in 5–8-Sekunden-Clips, legen Seeds fest, dokumentieren Ihre Prompts – und iterieren in kleinen Schritten. Kleine Prompts, große Wirkung.

Pika Text-zu-Video Anleitung und Beispiele

- Neues Projekt öffnen. Prompt klar strukturieren: „Wide shot of neon-lit street, rain at night, reflective asphalt, slow dolly forward, shallow depth of field, cinematic, 24fps.” 2) Aspect Ratio wählen (9:16 für Shorts, 16:9 für YouTube). 3) Seed fixieren, um reproduzierbare Varianten zu testen. 4) Style-Preset wählen (z. B. „Cinematic”). 5) Optional Referenzgrafik für die Farbwelt hochladen. 6) Rendern – dann gezielt Varianten: mehr Regen, langsamerer Dolly, wärmere Lichter.

Beispiel aus einem Sneaker-Teaser: Drei 6-Sekunden-Clips mit leicht variierenden Kamerafahrten erzeugt, anschließend im Schnitt kombiniert. Ergebnis: 18 Sekunden stimmige Intro-Sequenz in unter 90 Minuten. Tipp: lieber drei kurze, kohärente Takes als ein langer, der zerfasert. Fragen Sie sich bei jedem Durchlauf: Was ist der „Hero Moment“ dieses Shots?

Runway Gen-3 Text-zu-Video Tutorial auf Deutsch

Runway glänzt, wenn Schnitt und Post-Work im Fokus stehen. Workflow: 1) Neues Text-to-Video starten, Prompt nach Filmlogik formulieren (Shot-Typ, Subjekt, Aktion, Umgebung, Licht, Linse, Bewegung). 2) Falls verfügbar: Camera Controls und Motion-Parameter justieren. 3) Negative Prompts nutzen (z. B. „no text overlays, no watermark, no glitch”). 4) Nach dem Rendern im Editor Tempo, Farbe, Schärfe und Stabilisierung feinjustieren; bei Bedarf Upscaling nutzen. 5) Varianten zusammenfügen, Übergänge setzen, Export im richtigen Format.

Kurzer Case: Eine Agentur erzeugte mit Runway aus drei Prompts einen 15-Sekunden-Moodfilm für einen Pitch – vom ersten Prompt bis zum finalen Export in knapp vier Stunden, inklusive Color-Matching auf Markenfarben. Time-to-First-Draft schlägt fast alles. AI Text to Video ist hier der Schnellbohrer, nicht der Endausbau. Die Finishing-Arbeit im Schnitt bleibt Gold wert.

Rechtliche Hinweise für AI-Videos: Urheberrecht, Lizenzen, Marken

Bei GenAI-Video zählt nicht nur, was machbar ist, sondern was erlaubt ist. Rechteklärung, Musik, Stock, Logos – alles hat Regeln. Wer sie kennt, fährt entspannter und sicherer.

Wer ist Urheber? Trainingsdaten, Output und Rechteklärung

Die Rechtslage entwickelt sich. In vielen Jurisdiktionen gilt rein maschinell erzeugter Output nicht als klassisch urheberrechtlich geschützt. Plattformen räumen Nutzern oft weitgehende Nutzungsrechte am Output ein – die Trainingsdaten sind ein eigener Komplex. Prüfen Sie daher die AGB der Anbieter und verfolgen Sie Rechtsentwicklungen wie den EU AI Act.

Ein pragmatischer Ansatz: Prompts, Seeds, Referenzen und eigene Assets dokumentieren. Je mehr menschliche Kreativleistung und Compositing in der Pipeline stecken, desto klarer die eigene schöpferische Prägung. Und: Separate Lizenzen für Musik, Stimmen, Fonts und Stock-Footage bleiben notwendig.

Kein generierter Clip ersetzt die Rechteklärung. Wer Output nutzt, sollte Herkunft, Lizenzen und mögliche Konflikte mit Marken- oder Persönlichkeitsrechten prüfen.

Musik, Stock, Logos: Was Sie lizenzieren oder vermeiden sollten

Musik braucht Rechte – ob Library, GEMA-frei oder individuell lizenziert. Bei freien Materialien sind die Lizenztexte entscheidend: Bei Creative Commons sind „BY“-Pflichten üblich, „NC“ verbietet kommerzielle Nutzung, „SA“ erfordert identische Weitergabe. Prüfen Sie immer die genaue Fassung beim Anbieter oder bei Creative Commons.

- Klare Musiklizenz wählen; Metadaten mit dem Projekt verknüpfen.

- Stock-Bilder/-Videos nur mit passender Lizenz und Quellenangabe nutzen.

- Marken, Designs und Logos nur mit Erlaubnis oder als zulässiges Beiwerk – Details bei der EUIPO.

- Erkennbare Personen? Persönlichkeitsrechte und Einwilligungen beachten.

- Plattform-AGB zu Output-Nutzungsrechten und Haftung lesen.

AI Text to Video ist keine rechtliche Grauzone per se – aber jeder Use Case hat eigene Regeln. Vorsicht ist hier kein Bremsklotz, sondern ein Sicherheitsgurt. Warum erst im Nachgang klären, wenn’s vorher schneller und stressfreier geht?

Prompt-Tipps und Best Practices für bessere Text-zu-Video Ergebnisse

Gute Prompts sind wie gute Regieanweisungen: konkret, bildhaft, messbar. Struktur ist Ihr bester Freund – und Seeds sind Ihr Gedächtnis.

Prompt-Struktur, Seeds, Referenzen und Parameter

Starten Sie mit einer klaren Sequenz: Shot-Typ (z. B. „wide shot”), Subjekt, Aktion, Umgebung, Lichtstimmung, Optik („35mm lens, shallow DOF”), Kamerabewegung („slow dolly forward”), Stil („cinematic, high contrast”), Framerate. Seeds nutzen, um Varianten vergleichbar zu machen. Referenzbilder helfen bei Colorways, Logos (sofern lizenziert) oder Materialsprache. Parameter wie Guidance Scale, Motion Strength, Depth/Edge-Conditioning oder Kamera-Pfade geben Feinkontrolle.

Arbeitsregel aus der Praxis: erst Realismus sichern (Konsistenz, Licht, Bewegung), dann Stil aufdrehen. Wer Datenblätter liest, filmt besser – auch ohne Set.

Qualitätskontrolle: Iteration, Upscaling, Color, Motion

Nach dem ersten Render kommt der zweite Blick: Kanten stabil? Bewegung glaubwürdig? Licht konsistent? Planen Sie pro Clip 2–5 schnelle Iterationen ein und fixieren Sie Seeds, sobald eine Richtung trägt. Danach in den Editor: trimmen, Geschwindigkeit, Color Match, Schärfen, ggf. Upscaling.

- Erst den „Hero Shot” sichern, dann Varianten bauen.

- Negative Prompts nutzen, um Text-Artefakte, Wasserzeichen oder Glitches zu minimieren.

- Kamera-Pfade sparsam einsetzen; zu viel Motion wirkt unstet.

- Kürzere Clips generieren und im Schnitt verbinden – statt langer, brüchiger Sequenzen.

- Farben früh definieren (Palette/Brand), später nur noch fein justieren.

AI Text to Video ist ein Beschleuniger – und gute Post bleibt der Qualitätshebel.

Fazit und nächste Schritte (inkl. FAQ)

Jede Produktion ist anders, doch ein Muster bleibt: schnell testen, sauber nachbearbeiten, rechtlich absichern. So schöpfen Teams den echten Vorteil aus.

Wie realistisch sind AI-Text-zu-Video-Clips aktuell und wofür taugen sie?

Bei kurzen Shots unter kontrollierten Bedingungen ist die Qualität erstaunlich hoch. Landschaften, Objekte, stylisierte Szenen: überzeugend. Bei Menschen, Händen, feinem Lippen-Sync und längeren Erzählketten wird es labil. Ideal: Social-Ads-Iterationen, B-Roll, Previsualization, Pitch-Moodfilme, stylisierte Produktteaser.

FAQ in Kurzform: Dauer? Sekunden bis Minuten pro Clip. Kosten? Von Freikontingenten bis zu Abo-/Credit-Modellen. Rechte? Output-Nutzung meist erlaubt, aber Musik/Logos/Personen separat lizenzieren. Workflow? Kurz generieren, schneiden, graden – dann ausspielen.

Erwartungsmanagement hilft: KI liefert Rohstoff, kein Endprodukt. Der Schnitt macht den Film.

Fazit: Nächste Schritte für Creator (Workflow, Budget, Recht)

Starten Sie mit einem Mini-Briefing: Ziel, Format, Stil, 2–3 Referenzen. Wählen Sie Ihr Tool-Setup: z. B. Pika für Ideation, Runway für Feinschliff. Planen Sie ein Basisbudget für 1–2 Monate Tests (Credits + Zeit im Schnitt). Legen Sie eine Prompt-Bibliothek an und protokollieren Sie Seeds/Parameter; Wiederholbarkeit spart Tage. Prüfen Sie Lizenzen für Musik, Stock und Marken frühzeitig und behalten Sie die AGB der Plattformen im Blick – besonders bei kommerzieller Nutzung.

AI Text to Video ist heute schon wertvoll: als Turbo für Ideen, als Generator für B-Roll und als Previs-Werkzeug. Wer jetzt Hands-on wird, baut das Know-how auf, das in sechs Monaten Standard ist. Der beste Zeitpunkt zum Testen war gestern. Der zweitbeste ist jetzt.

Hey, ich bin Karwl und das ist mein Blog. Ich liebe alles zu den Themen 🌱 Garten & Pflanzen, 🤖 KI & Tech, 🌐 Web & Coding und würde mich freuen, wenn du hier öfters mal vorbei schaust.